この記事は「ウィルゲート Advent Calendar 2024」の 3日目の記事です。 adventar.org

こんにちは、インフラユニット所属の加藤です。

今回は、収集したログをDatadogで効果的に利用・分析できるように変換する「パイプライン機能」について紹介します。Datadogを使ったログ分析に役立つ、パイプラインの基本的な使い方やプロセッサーの実例を通して、その効果と使い方を詳しく解説していきます。

前編と後編に分けてパイプラインの主要機能をご紹介します。前編ではパイプラインの全体像とフィルター機能を取り上げます。

Datadogのパイプラインとは?

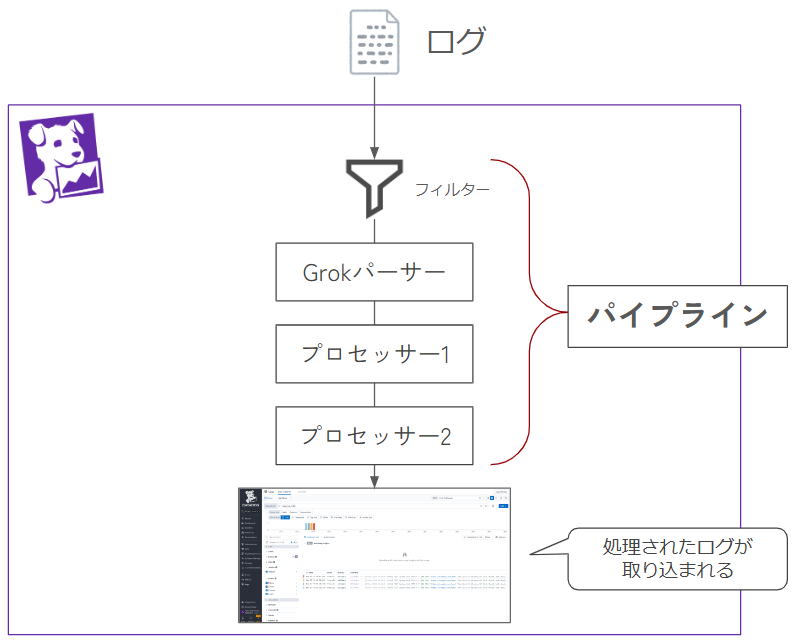

パイプラインとは、Datadogに送信されたログを順次処理し、分析しやすい形式に変換する一連のプロセスです。 この機能を活用することで、以下の操作が可能になります

- 非構造化ログを構造化ログ(JSON形式)に変換

- ログに新たな属性を追加

パイプラインによるログ処理の全体像は以下のようになっています。

パイプライン機能によるログ処理の効果

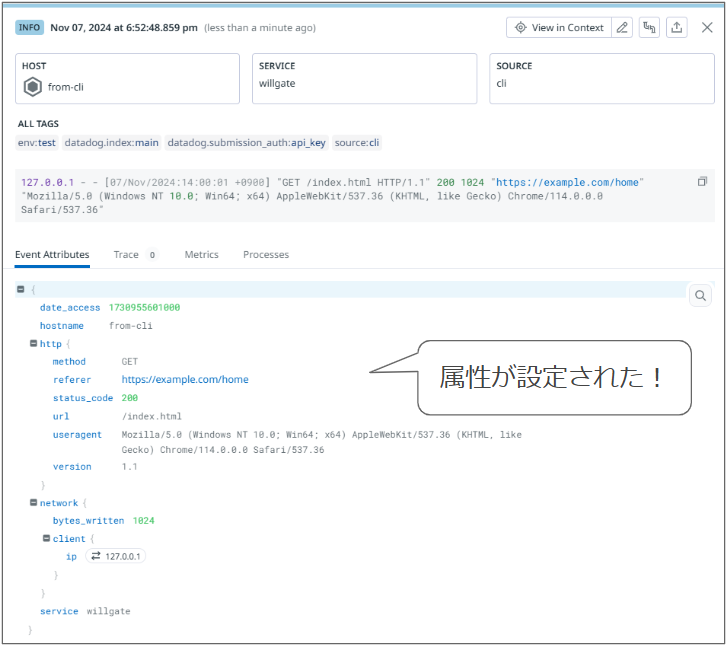

パイプラインによって処理したログと、処理前のログを比較すると、分析のしやすさが大きく変わります。

処理前のログ

非構造化の状態で、属性がほとんど付与されていないため、フィルタリングや検索、可視化がしにくくなっています。

処理後のログ

JSON形式に変換され、各種属性が追加されました。これにより、フィルタリング、検索、グラフ表示などがしやすくなり、分析や可視化が格段に向上します。

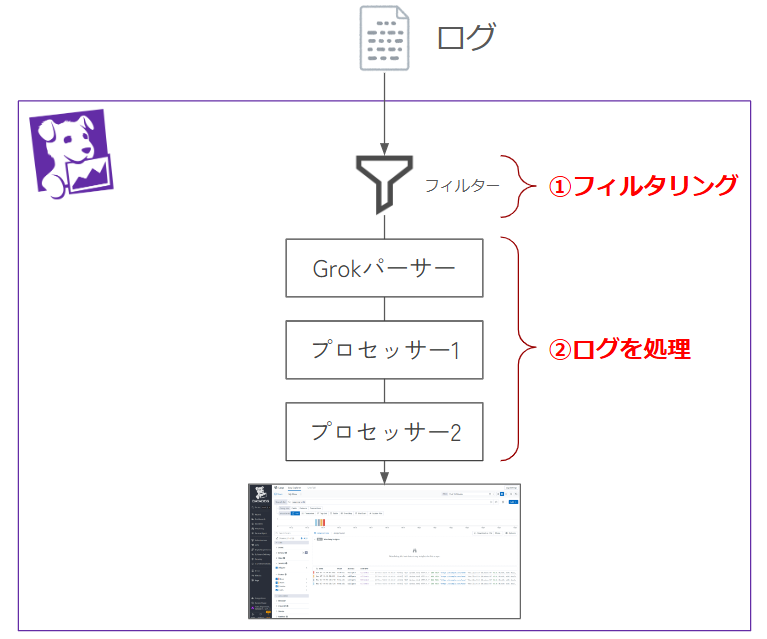

パイプラインの基本的な使い方

パイプラインの使い方は以下の通りです。

1. フィルターで処理対象のログを絞り込む

2. プロセッサーを使用してログに必要な属性を付加する

本記事は前編として、1. フィルターで処理対象のログを絞り込むをご紹介します。

フィルターで処理するログの絞り込み

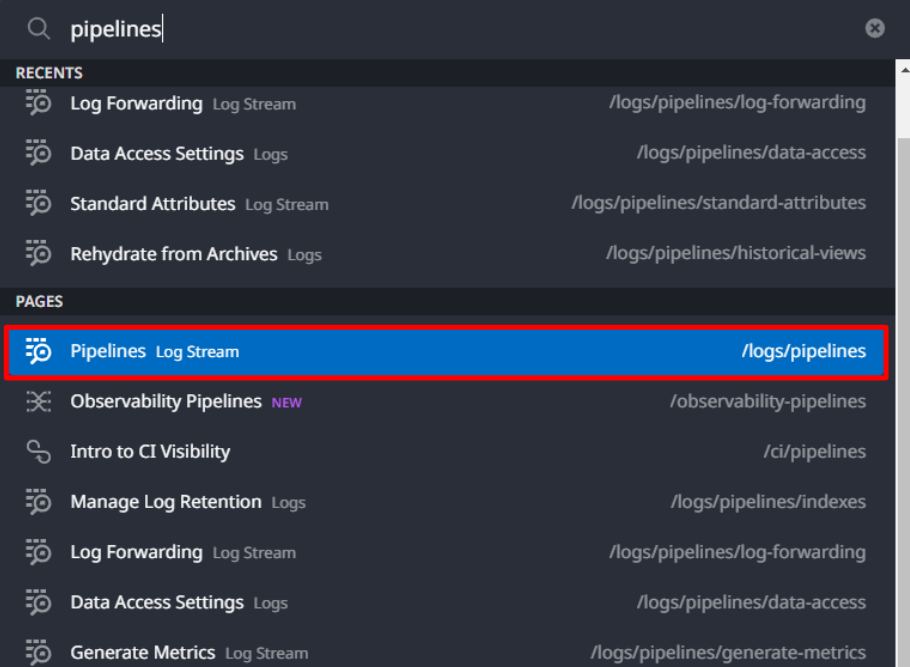

DatadogのダッシュボードでPipelinesを検索してアクセスします。

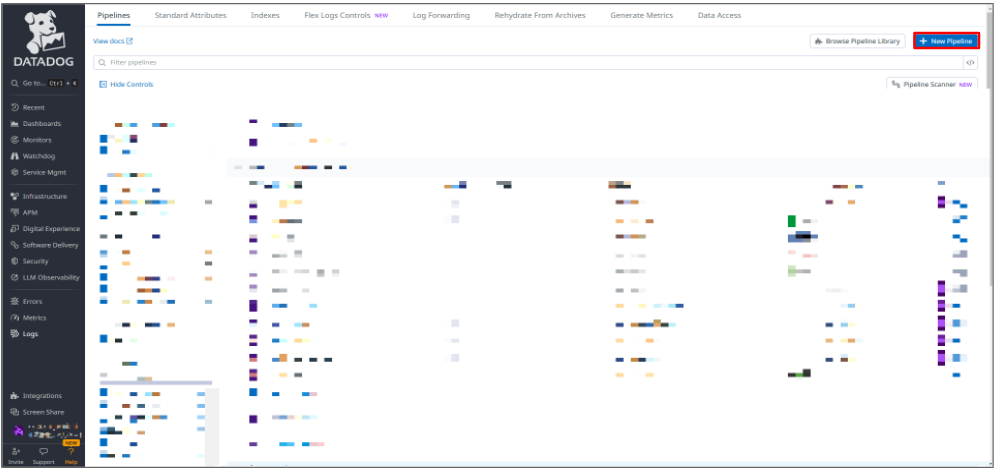

+New Pipelineをクリックして、新しいパイプラインを作成します。

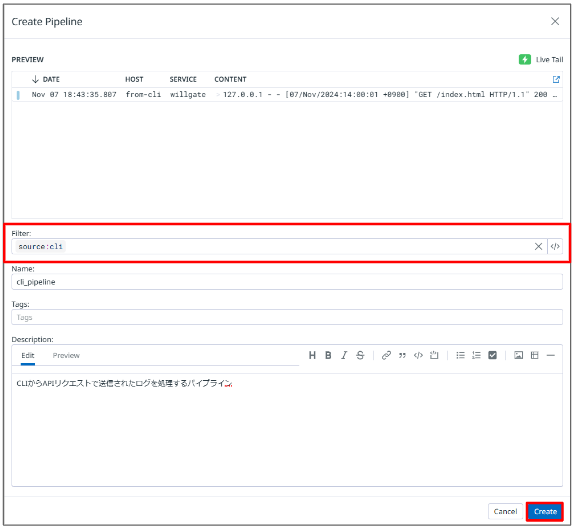

Filterに条件式を入力し、対象のログを指定します。たとえば、source:cli と入力すると、CLIから送信されたログが対象になります。

※検証のためAPIを使いログを送っています。やり方はこちらの記事を参照ください。

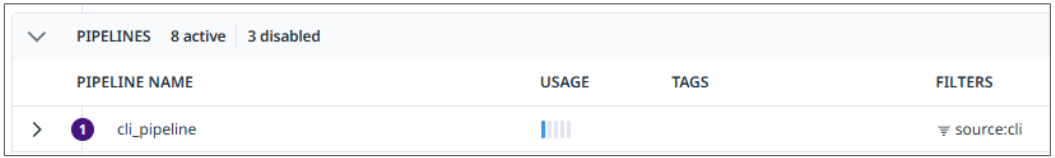

これでパイプラインが作成されました。

このパイプラインにプロセッサーを追加することで、ログの構造化や属性の追加が可能になります。

まとめ

前編では、パイプライン機能の全体像とフィルターで処理対象のログを絞り込む方法をご紹介しました。

後編では、パイプラインにプロセッサーを追加し、ログの構造化や属性の追加をご紹介します。

「ウィルゲート Advent Calendar 2024(https://adventar.org/calendars/10272)」、翌日は後編の「ログ分析をより便利に!Datadogパイプラインの活用法【プロセッサー・後編】 」です。 お楽しみに!